Stellen Sie sich vor, Sie könnten in Echtzeit geschäftliche Vorgänge prüfen und steuern. Oder Ihre Kunden mit innovativen Services begeistern und langfristig binden. Echtzeitanalysen eröffnen Unternehmen vollkommen neue Möglichkeiten, um sich auf Basis ihrer Daten einen Vorsprung gegenüber dem Wettbewerb zu verschaffen. Vor allem im Produktionsumfeld hält die Auswertung von Echtzeitdaten zunehmend Einzug – etwa bei der Überwachung von Maschinen. Störungen lassen sich dadurch frühzeitig erkennen und die Verfügbarkeit der Anlagen deutlich erhöhen.

Aber auch andere Branchen können von Echtzeitszenarien nachhaltig profitieren. Jedoch mangelt es vielen Unternehmen an Mut und einem richtigen Plan. Selbst wenn die richtigen Daten und gute Ideen vorhanden sind, fürchten die Verantwortlichen den Aufwand und kostspielige Fehlläufe. Dabei lassen sich Echtzeitlösungen inzwischen viel einfacher umsetzen, als allgemein angenommen. So bietet die Microsoft Azure Cloud mit Databricks einen vollständig gemanagten Analysedienst für Massendaten, der in wenigen Klicks aufgesetzt ist und sehr günstig betrieben werden kann.

Im Folgenden möchte ich diesen Dienst und seine Möglichkeiten in einem Echtzeitumfeld näher beschreiben. Anschließend zeige ich anhand eines Beispiels, wie Sie Echtzeitanalysen für den Handel mit Databricks umsetzen und in neue Werte für das Geschäft, die Kunden sowie die eigenen Mitarbeiter überführen können.

Effiziente Verarbeitung von Massendaten

Technologisch basiert Azure Databricks auf der Big-Data-Plattform Apache Spark, die bereits seit vielen Jahren eine effiziente Verarbeitung, Transformation und Analyse großer Datenmengen für ganz unterschiedliche Nutzergruppen in Unternehmen möglich macht. Allerdings hat der Cloud-Dienst einige entscheidende Vorteile: Er ist nicht nur vollständig gemanaged, sodass dem Nutzer eine mühevolle Konfiguration erspart bleibt. Es wurden auch eine Reihe wichtiger Funktionen ergänzt, die einen stabilen Betrieb und eine gute Performance gewährleisten.

Und: Rechen- und Speicherkapazitäten sind flexibel skalierbar, wodurch anspruchsvolle Analyseszenarien aus dem Echtzeitbereich erst möglich werden. So verarbeitet Databricks hochvoluminöse Daten parallel über verschiedene Knotenpunkte – die sogenannten Worker Nodes. Ein Knoten entspricht dabei einer Computereinheit mit einer vorab festgelegten Menge an CPU und RAM-Speicher. Bei Bedarf können jederzeit weitere Worker Nodes hinzugenommen werden.

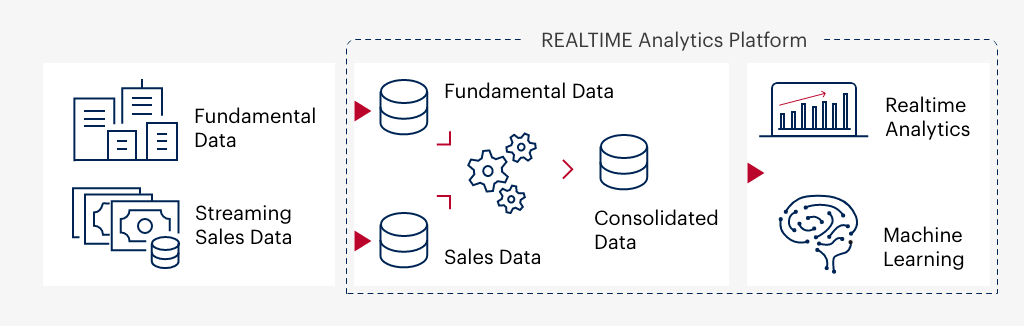

Auf dieser Grundlage kann Databricks sowohl klassische Stammdaten aus einem Data Warehouse (DWH) als auch Datenströme von Echtzeit-Devices verarbeiten. Beide Pfade sind für die Echtzeitanalyse wichtig. Denn: Zahlenwerte aus einem Echtzeit-Streaming werden im Regelfall erst durch die Kombination mit DWH-Daten verständlich und interpretierbar. Daher schauen wir uns im nächsten Schritt eine entsprechende Architektur in Databricks an, die wir für ein Handelsunternehmen aufgebaut haben.

Echtzeitanalysen für den Handel: Aufbau der Architektur

Die Architektur für unseren Handelskunden basiert auf zwei Datenpfaden (Abb. 1): Auf der einen Seite gibt es die „Fundamental“-Daten – konkret: historische Verkaufsdaten, die nach einem klassischen DWH-Ansatz beladen werden. Sie werden also aus der Quelle extrahiert, aufbereitet und für die weitere Analyse abgespeichert bzw. bereitgestellt. Die andere Seite überträgt laufend die „Streaming Sales Data“ – sprich: aktuelle Verkaufszahlen der Produkte mit den jeweiligen Mengenangaben und Preisen. Nur diese Prozessdaten verarbeitet das System in Echtzeit, während es die Stammdaten zu den jeweiligen Produkten aus dem DWH bezieht. Auf diese Weise entsteht eine schlanke Echtzeit-Strecke, bei der sich Streaming- und Stammdaten sinnvoll ergänzen.

Daneben werden die Streaming-Daten auch im DWH abgelegt. So lassen sie sich im Nachgang auch noch für historische Analysen nutzen. Zudem stellt ein eingebauter Check-Point-Mechanismus sicher, dass die Daten nach Unterbrechung eines Streams an der richtigen Stelle weiterverarbeitet werden, an welchem der Stream abgebrochen ist.

Konkrete Anwendungsszenarien für den Handel

Wir haben die beschriebene Architektur im Rahmen einer digitalen Plattform in der Microsoft Azure Cloud umgesetzt. Die beiden Datenströme werden mit Databricks verarbeitet und in Power BI als Echtzeit-Dashboards dargestellt, die sich über den Tag hinweg laufend aktualisieren (Abb. 2). Für das Handelsunternehmen ergeben sich daraus eine Vielzahl von Anwendungsszenarien zur Optimierung des Geschäftes.

In unserem Dashboard-Beispiel vergleichen wir die Abverkäufe der Filialen in Dortmund, Düsseldorf, Köln und Neuss, wobei Änderungen in Echtzeit erscheinen. Auf der Detailebene lässt sich erschließen, wie sich einzelne Produkte in den verschiedenen Filialen verkaufen. In der Folge können die Verantwortlichen den Absatz steigern, indem sie beispielsweise Waren umlagern, wenn diese in einer Filiale besonders gefragt sind. Genauso kann die erfolgreichere Filiale als Vorbild für Handlungsempfehlungen etwa zur Warenplatzierung in anderen Filialen dienen. Auch ganz allgemein lassen sich im Zuge der gewonnen Erkenntnisse die Abverkäufe von weniger nachgefragten Artikel durch kurzfristige Maßnahmen stimulieren.

Zudem besteht die Möglichkeit, die gewonnenen Daten mit externen Quellen zu kombinieren. So können anhand von demografischen Daten spezifische Verkaufsmuster abgeleitet werden, durch die sich das Sortiment genauer auf die Zielgruppen ausrichten lässt. Der Erfolg – auch von neuen Bestandsartikeln – kann daraufhin sowohl in Echtzeit als auch historisch betrachtet werden. Die Hinzunahme von Wetterdaten lohnt sich für das Unternehmen vor allem bei historischen Analysen, die das Konsumverhalten bei spezifischen Wettergegebenheiten widerspiegeln. Dabei mag es nicht verwunderlich sein, dass im Sommer der Eisverkauf drastisch zunimmt. Allerdings werden durch solche Analysen auch Zusammenhänge aufgedeckt, die weit weniger offensichtlich sind.

Wollen auch Sie Databricks nutzen, um mit Echtzeitszenarien Ihr Geschäft zu verbessern und Kunden zu begeistern? Dann nutzen Sie unser Modern Data Warehouse Training.

Kommentare (0)