Wie werden Big Data kommerziell erschlossen?

Wenn von „Big Data“ die Rede ist, dann ist auch immer Big-Data-Technologie für die Verarbeitung und geschäftliche Analyse der Daten gemeint. Dabei waren es vor allem die unternehmenseigenen Rechenzentren, die noch bis vor wenigen Jahren einer kommerziellen Nutzung von Big Data klare Grenzen setzten. Big Data sind zu umfangreich, komplex und schnelllebig, um sie mit einem klassischen Data Warehouse und Business-Intelligence-Methoden zu erschließen. Ein etwaiger Ausbau der Datenlandschaft wäre sehr kostspielig und schwer planbar.

So haben sich Big-Data-Analysen erst mit den Fortschritten beim Cloud Computing zunehmend als Standard für Unternehmen etabliert. Die Enterprise-Angebote bekannter Cloud-Provider – wie Microsoft, Google oder Amazon – ermöglichen es den Verantwortlichen nicht nur, schnell und effizient eine moderne Daten-Infrastruktur mit allen notwendigen Komponenten aufzubauen.

Ebenso kann die Datenverarbeitung und Datenspeicherung ganz nach Bedarf skaliert werden, sodass sich im Prinzip jeder erdenkliche Anwendungsfall für Big Data wirtschaftlich realisieren lässt. Hierzu zählen auch die Vernetzung von Objekten und Maschinen über das Internet of Things (IoT) sowie Machine Learning zur Entwicklung von Künstlicher Intelligenz (KI).

Wo werden Big Data in der Praxis eingesetzt?

Die Einsatzgebiete von Big Data sind so breitgefächert, wie die ursprünglichen Quellen. Für beinahe jedes Unternehmen gilt: Wo Big Data entstehen, lassen sich auch neue, datenbasierte Potenziale heben.

Eine performante Verarbeitung von Big Data bildet die Grundlage für die Optimierung von Produktionsprozessen

Im Folgenden einige Beispiele:

Produktion

Durch die Echtzeitanalyse von Maschinendaten werden Störfälle vorhersagt und Wartungsintervalle optimiert. Eine Vernetzung aller Maschinen und Produktionsstandorte über das IoT ermöglicht eine Verbesserung und Automatisierung von Prozessen im gesamten Unternehmen.

Handel

Mit vollständigen Daten aus Kaufprozessen, Kundenkarten, Anrufprotokollen, Social Media, Website-Verhalten etc. lassen sich Kunden gezielt ansprechen. Währenddessen kann die Auswertung tagesaktueller Verkaufsdaten zur Steigerung von Umsätzen und Senkung von Abschriften beitragen.

Finanzindustrie

Die umfassende Analyse von Transaktionsmustern bildet eine valide Grundlage zur Vorhersage von Betrugsfällen. Erforderliche Daten lassen sich in Echtzeit visualisieren. Gesetzte Grenzwerte und Alarming-Funktionen weisen unmittelbar auf Verstöße hin.

Gesundheitswesen

Auf Grundlage von Patientendaten können Diagnose- und Behandlungsmethoden verbessert sowie der Ausbreitung von Epidemien vorgebeugt werden. Neue Erkenntnisse aus Wissenschaft und Forschung lassen sich nahezu in Echtzeit erschließen und verbreiten.

Energieversorger

Live-Datenflüsse aus smarten Devices und Systemen schaffen volle Transparenz zu Energieverbräuchen und dem künftigen Bedarf. Einsparpotenziale werden offensichtlich, sodass sich sowohl die Verbraucherkosten als auch der Ressourceneinsatz optimieren lassen.

Big Data Analytics als Ausgangspunkt für neue Geschäftsmodelle

Die Beispiele verdeutlichen, dass die Kombination aus Big Data und Big-Data-Technologien auch das klassische Reporting vollkommen neu definiert. Es wandelt sich zunehmend zur intelligenten Entscheidungsvorlage, die eine vorausschauende Unternehmenssteuerung in Echtzeit ermöglicht. Grundlage bildet – wie in allen Big Data Cases – eine zentrale Daten-Plattform, die große Datenmengen performant integrieren, aufbereiten und bereitstellen kann.

Wie wird eine Big-Data-Plattform aufgebaut?

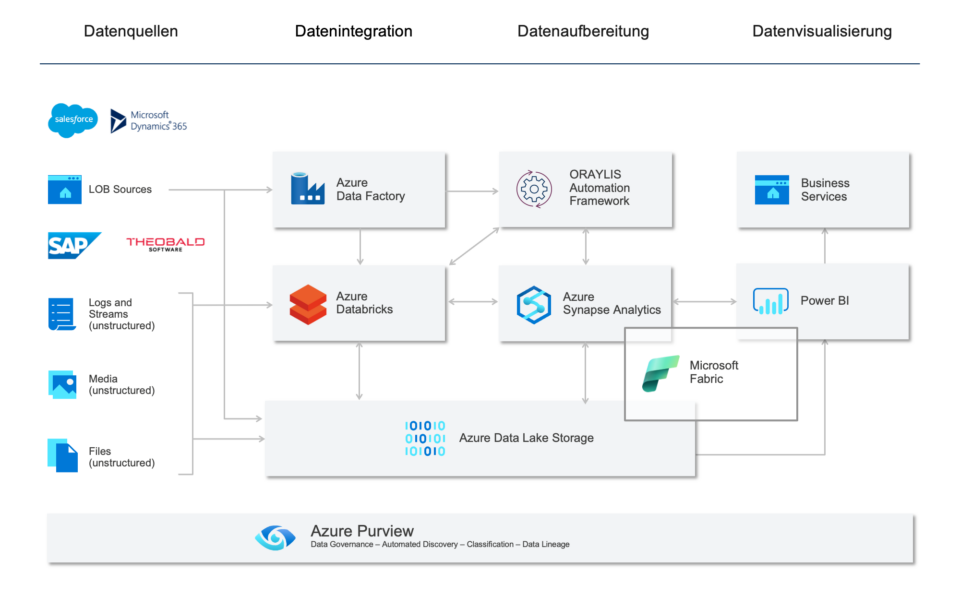

Mit den Cloud-Services der etablierten Dienstleister lassen sich vollständige Big-Data-Plattformen von der Datenintegration über die Datenaufbereitung bis hin zur Datenvisualisierung aufbauen. Ein besonders ausgereiftes Konzept bietet das Azure Data Lakehouse von Microsoft. Es verbindet bewährte Azure-Komponenten mit Databricks als Kernelement der Datenverarbeitung. Gegenwärtig handelt es sich um die wirtschaftlichste und zugleich performanteste Lösung, um Big Data für die Analyse großer Datenmengen.

Aufbau einer Big-Data-Architektur mit den Services der Microsoft Azure Cloud.

Das Azure Data Lakehouse führt die verschiedenen Datenbestände von Unternehmen an zentraler Stelle zusammen. Big-Data-Streams werden einerseits im Rohformat in einem unbegrenzt skalierbaren Data Lake gespeichert. Andererseits werden die Datenströme über eine Echtzeitstrecke unmittelbar für geschäftliche Analyseszenarien bereitgestellt. Eine Verknüpfung mit den ebenfalls im Data Lake abgelegten, qualitätsgesicherten Stammdaten sorgt dabei für die notwendige Aussagekraft. Die Ergebnisse werden dann als konsolidierte Datenprodukte wiederum zurück in den Data Lake gespielt. Zudem haben Analysten einen Zugriff auf die gesamten Daten, um explorative Analysen durchzuführen und mittels Data Mining neue Erkenntnisse für das Geschäft zu gewinnen. Nicht zuletzt lässt sich das Lakehouse-Konzept von Microsoft zu einem Data Mesh mit dezentraler Datenverantwortung ausbauen.

Wollen auch Sie sich die Vorteile von Big Data zu Nutze machen? Dann schauen Sie doch mal im Bereich Big Data Engineering vorbei oder informieren Sie sich über unser Training Data Lakehouse – Cloud-Plattformen aufbauen und geschäftlich nutzen.

turn your data into value.